Stories

Rund 12.000 Studierende und 1.600 Mitarbeiter, von denen montags bis freitags bis zu 6.000 mit unterschiedlichen Devices gleichzeitig online sind: Hoch über den Köpfen der Studenten und dem Mannheimer Schloss, im elften Stockwerk des RUM Gebäudes muss das Rechenzentrum der Universität Mannheim in etwa die gleiche Leistung erbringen, wie die Rechenzentren von Unternehmen wie KUKA oder Zalando. Ein 15-köpfiges Team ist dafür zuständig, den laufenden Betrieb des Datennetzes, der Medientechnik sowie der Infrastruktur zu gewährleisten. Keine spielend leichte Aufgabe, bei einer Auslastung des Backbones, dem zentralen Netz der Universität, mit 10 GBit pro Sekunde, 6.000 am LAN angeschlossenen Rechnern, 600 Switches und 500 WLAN-APs. Die Leistungsfähigkeit des Rechenzentrums wird dabei durch zwei wichtige Komponenten sichergestellt: dem Forschungsclusterrechner der Universität und einer smarten Kühlungslösung.

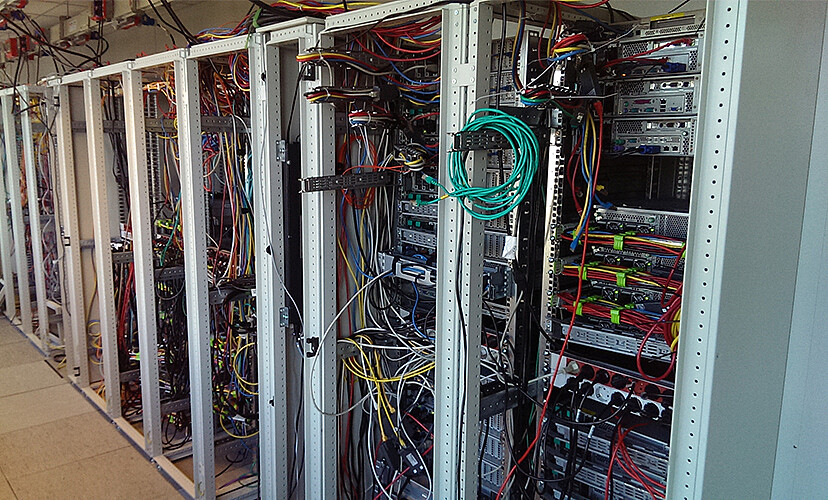

Eigentlich wollte die Universität in Mannheim 2010 die Klimatechnik, respektive die Kühlleiter im Maschinenraum erneuern, um sie der gestiegenen Rechenleistung anzupassen. Nach der Analyse der Ist-Situation entschied sich Ralf-Peter Winkens, Leiter der Abteilung Datennetz und Medientechnik im Rechenzentrum, dann doch für die Neuplanung des kompletten Datacenters. Um den laufenden Betrieb zu gewährleisten, wurde das Projekt in fünf Bauabschnitte unterteilt. Pro Abschnitt wurde zunächst ein Bereich freigeräumt und anschließend mit der neuen Hardware bestückt. Seit August 2015 stehen nun auf 100 Quadratmetern insgesamt 53 Racks und 21 Seitenkühler. Für den Ausbau des Rechenzentrums wurde mit insgesamt vier Teilaufträgen SCHÄFER IT-Systems, eine Tochter der in Neunkirchen im Siegerland ansässigen SCHÄFER WERKE, betraut. Als Hersteller von Netzwerk- Serverschrank- sowie Rechenzentrumslösungen lieferte und installierte das Unternehmen auch die Hardware.

„Ich habe zunächst mehrere Unternehmen geprüft und mich dann für Schäfer entschieden. Ausschlaggebend war dabei das Konzept. Das Unternehmen verbaute schon 2010 die Kühler nicht in den einzelnen Schränken, sondern setzte auf einen zentralen Kaltgang. Diese Variante ist nicht umsonst besser und sicherer: Heute sind Kaltgangeinhausungen Standard“, sagt Winkens. Die Qualität und Leistungsfähigkeit der Kühlung spielte für ihn eine maßgebende Rolle, denn eine Besonderheit des Rechenzentrums der Universität Mannheim ist ihr „Superrechner“. Er belegt Platz 80 unter den Top 100 schnellsten Rechnern der Welt. Bei voller Nutzung aller Leistungen des Datencenters entsteht eine maximale Wärmelast von 220 Kilowatt, von der allein der Superrechner 150 Kilowatt beansprucht.

Das steigert entsprechend die Anforderung an die Klimatechnik. Zum einen befindet sich das Rechenzentrum mitten in der Quadratestadt im 11. Stockwerk des RUM-Gebäudes, andererseits auch direkt unter dem Dach, um die Wege für die Kühlung kurz zu halten. Diese erzeugt die Kälte zum anderen durch drei Teilelemente: Die konventionelle Kühlung sichert ein Kompressor mit rund 220 Kilowatt Kälteleistung, der direkt auf dem Dach des Gebäudes steht. Eine zusätzliche indirekte, freie Kühlung mit 20 Quadratmetern Kühlerfläche auf dem Dach nimmt durch Ventilatoren die Umgebungskälte aus der Luft und kühlt den Gesamtkreislauf auf dem Weg zu den Loopus-Coolern. Diese sind eine wassergekühlte Rack-Klimatisierungslösung, die in diesem Fall seitlich geschlossen, jedoch vorne und hinten offen sind. Die Seitenkühler saugen erwärmte Luft von hinten aus dem Raum an und blasen sie gekühlt in den eingehausten Kaltgang. Auf diese Weise lassen sich hohe Wärmelasten pro Rack und zugleich eine flexible und effektive Klimatisierung bewältigen. Eine direkte, freie Kühlung bläst als drittes Element der Kühlung zudem 8.800 m³/h Außenluft direkt in den Warmgangbereich ein und entlastet damit wiederum gleichzeitig den Kompressor auf dem Dach.

Schließlich gewährleistet eine Notkühlung mit insgesamt 70 kW den Betrieb der Systeme für den Fall einer Störung. Sie besteht aus sechs unabhängigen Split-Klimageräten, die an einem Notstromdieselgenerator angeschlossen sind. Winkens: „Ich bin sehr zufrieden. Die Leistungsstärke der Klimatisierung respektive die Qualität der Arbeit zeigen sich zunächst in der lückenlosen Versorgung. Aber auch in Details und in nicht planbaren Umständen. So musste der Superrechner in diesem Sommer mit maximaler Auslastung und daraus resultierend auch maximaler Kühlung getestet werden. Am dafür vorgesehenen Tag hatte es zusätzlich 35 Grad Außentemperatur. Die Kühlung hat den Test mit Bravur bestanden. Im Regelbetrieb geht es jedoch meist gemäßigter zu. Die 15.000 User nutzen im Wesentlichen den schnellen Internet-Zugang für ihre Web- und Mail-Anwendungen sowie die virtualisierte Server-Infrastruktur hauptsächlich für Verwaltungs- und eLearning-Dienste. Mit einer durchschnittlichen Wärmelast von 120 kW im Rechnerraum können dann auch die Köpfe unsere Plattenschränke kühl bleiben.“

Parallel wurde auf dem Campus ein Notfallrechenzentrum in Betrieb genommen. Rund 500 Meter vom eigentlichen Rechenzentrum entfernt stehen weitere SCHÄFER-Racks. Die sieben Notfalldatenschränke werden durch drei weitere Loopus Side-Cooler kühl gehalten. Im Notfallrechenzentrum ist jedoch nicht nur das Backup, sondern auch der Anfang der eigentlichen Leistung. So ist die Universität auch dort breitbandig an das BelWü, Baden-Württembergs extended LAN, angeschlossen. Das ist das wissenschaftliche Netzwerk des Bundeslandes, dem alle Universitäten und Fachhochschulen sowie über 1.000 Schulen angeschlossen sind. Gleichzeitig führt vom Notfallrechenzentrum eine eigene Leitung zum zentralen Internetknotenpunkt Deutschlands, dem DE-CIX, nach Frankfurt.

Auch auf Seiten SCHÄFERs zeigt man sich deutlich zufrieden. Thomas Wermke, Leiter Vertrieb IT: „Wir freuen uns, dass wir seit 2010 Partner der Universität Mannheim sind. Die Kontinuität ist Beleg für die langfristige Ausrichtung der Produktlösungen unseres Hauses. Außerdem resultieren aus den Gesprächen und Diskussionen mit der Forschungseinrichtung immer wieder neue Lösungs- und Produktideen.“